AI, czyli społeczna hipochondria XXI wieku

Obserwacja popularyzacji i spekulacji na temat AI, między innymi w mediach, dręczy pytaniem, czy to aby nie jeden z największych scamów XXI wieku? Opracowanie algorytmów stojących za fasadą AI jest niezaprzeczalnym osiągnięciem i postępem, ale czy wymaga to siania trwogi stojącej na niewiedzy wśród społeczeństwa? Podczas odpowiedzi na te pytania, dla uproszczenia, nie będę wchodził w szczegóły techniczne i przykleję etykietę sztucznej inteligencji do omawianych zagadnień.

Winę za sianie zbędnej trwogi ponoszą często szeroko pojęte media, wspierane przez pseudospecjalistów, produkujące masę artykułów – clickbaitów żerujących na zwykłym braku wiedzy, której przecież zwykły Kowalski nie musi posiadać. To niestety tworzy fałszywy obraz możliwości i przeznaczenia AI. Całość jest dodatkowo podsycana wyrastającymi ze środowiska social mediów, ekspertami AI. Znaczna część z nich przedstawia wyniki zwykłej regresji liniowej jako cudownych osiągnięć sztucznej inteligencji, gdzie prawda leży znacznie bliżej prostej zależności liniowej, dobrze znanej uczniom szkół średnich. Tak, to niezwykłe osiągnięcie... manipulacyjne.

Rozgłos i zainteresowanie tematem napędza powstawanie startupów wyciągających fundusze np. z NCBiR, żeby rozwijać produkty z wykorzystaniem AI, bo temat modny, fajny, chwytliwy, a prawda jest taka, że są to często projekty, których wykonanie powinno i może być wykonywane tylko i wyłącznie przy pomocy aparatu matematycznego i umiejętności programistycznych. Generowanie sztucznego rozgłosu prowadzi do sytuacji absurdalnych, takich jak np. pojawienie się artykułu w czasopiśmie naukowym, gdzie autorzy przy pomocy AI próbowali „wytrenować” fizykę do prostej symulacji układu planetarnego. To jak odkrywanie koła na nowo! Marnowanie sił i zasobów na badania, które nie mają przełożenia na rozwój dziedziny, powodując stagnację, a nawet zacofanie. Nie wspominając już o marnowaniu zasobów do tworzenia memów przy użyciu AI. Jaki jest sens wykorzystywania skomplikowanej sieci neuronowej, która działa jak czarna skrzynka (nie znamy interpretacji tych parametrów), jeśli wystarczy nauczyć się rachunku różniczkowego, całkowego, metod numerycznych i trochę starej dobrej mechaniki klasycznej?

Problem został tak rozdmuchany w różnych środowiskach, że nie obyło się bez kontrowersji. W 2024 roku komisja Noblowska przyznała Nagrodę Nobla w dziedzinie fizyki, uzasadniając to słowami:

Za fundamentalne odkrycia i wynalazki umożliwiające uczenie maszynowe przy użyciu sztucznych sieci neuronowych.

Jako fizyk teoretyk byłem tym werdyktem głęboko oburzony. To tak abstrakcyjne i absurdalne, że równie dobrze nagrodę mógłby otrzymać Cillian Murphy za odegranie roli Roberta Oppenheimera (patrz Rysunek 1). Jego związek z fizyką jest równie istotny, co nagrodzone osiągnięcia. Wśród potencjalnych kandydatów było wielu wybitnych naukowców, a jednak komisja zdecydowała się uhonorować aparat matematyczny – który sam w sobie nie jest fizyką – zamiast rzeczywistych osiągnięć w tej dziedzinie. Przypominam, że Nagroda Nobla nie jest przyznawana w dziedzinie matematyki.

Problemem o którym nie można zapomnieć przy okazji wykorzystywania AI do rozwiązywania problemów rozwiązywalnych standardowymi metodami, jest wykorzystanie zasobów obliczeniowych – czas i pamięć (wliczając energię). W porównaniu do AI, rozwiązania analityczne są zazwyczaj szybsze, dokładniejsze, wymagają mniej pamięci operacyjnej, a w rezultacie sprowadza się to do mniejszego zużycia energii. Takie zaniedbania są obecne w całym sektorze rozwijającym oprogramowania, nie tylko w rozwiązaniach wykorzystujących AI. Można odnieść wrażenie, że jakość oprogramowania spada, podczas gdy z roku na rok sprzęt jest coraz lepszy. Ten trend wyraźnie można zaobserwować w oprogramowaniach związanych z chmurą, czy stronami internetowymi, gdzie zasoby energii są wręcz pożerane. Wysuwając śmiałe założenia, można się pokusić o stwierdzenie, że wprowadzenie optymalizacji oprogramowania mogłoby zmniejszyć zapotrzebowanie energetyczne o ponad 95%, jednocześnie zwiększając efektywność czasową.

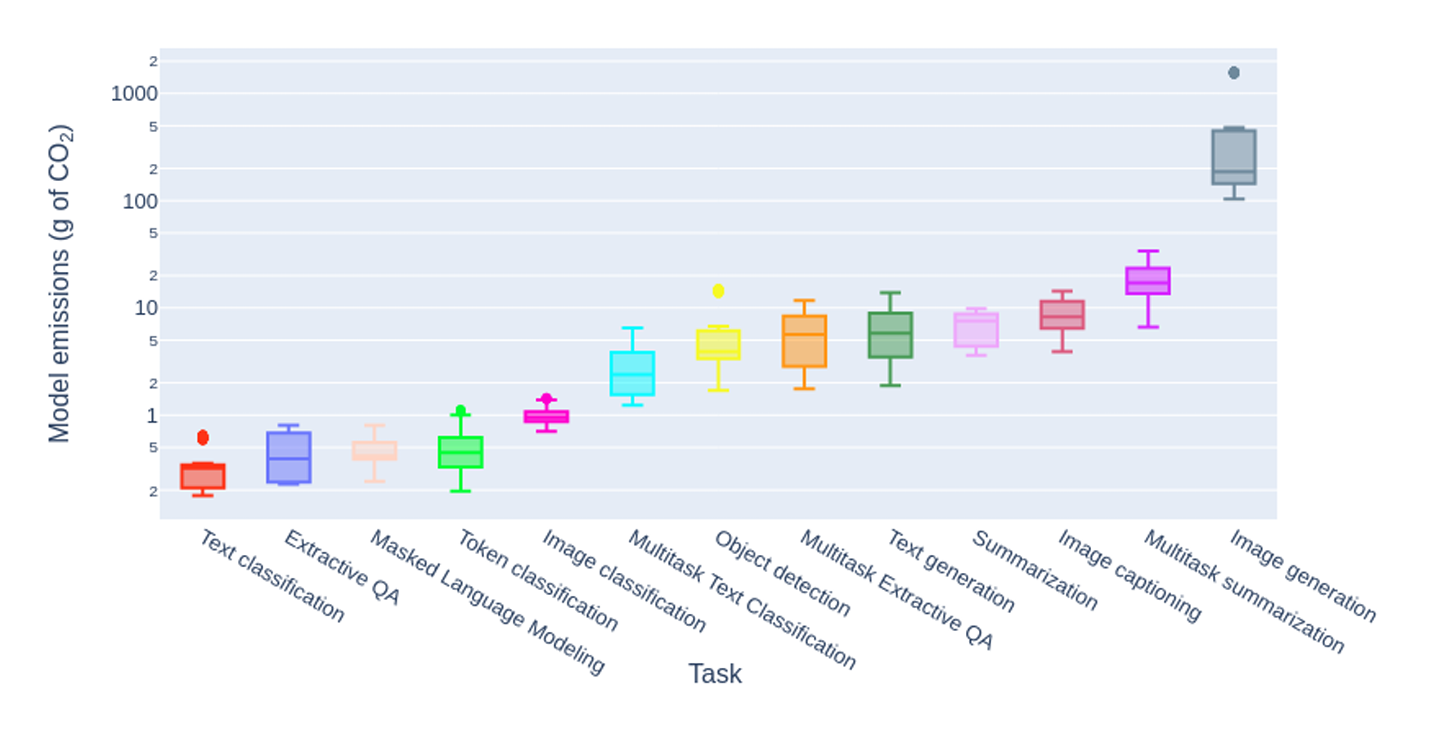

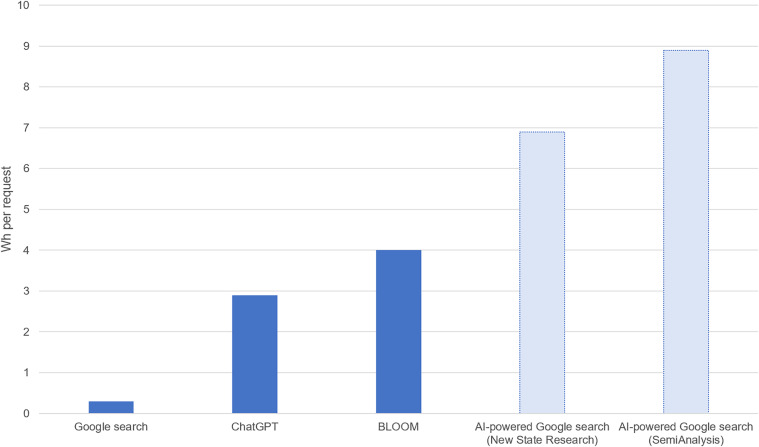

Rozwiązania AI charakteryzują się bardzo niską efektywnością (mam na myśli tutaj efektywność energetyczną, nie skuteczność poszczególnych algorytmów) – są niesamowicie energożerne. Szacuje się, że jedno zapytanie do ChatGPT, wygenerowanie obrazu (modele takie jak DALL$\cdot$E) czy 10-sekundowego wideo (SORA) zużywa odpowiednio 10, 50 i aż 10’000 razy więcej energii niż pojedyncze wyszukiwanie w Google (patrz Rysunek 2–3). To szczególnie przygnębiające, biorąc pod uwagę, że lepsze efekty można by osiągnąć, zatrudniając specjalistów, zamiast bezrefleksyjnie inwestować w hardware i bezmyślnie trenować „czarne skrzynki” do aproksymacji kiepskich rozwiązań.

W tym wszystkim radości mogą dostarczyć ludzie ze środowiska, którzy przerażeni prorokują, że za kilka chwil może nie być pracy dla programistów. Może to i prawda, ale tylko dla obszarów niewymagających od programisty ani krzty kreatywności. Inną grupą siejącą postrach są tzw. „foliowe czapeczki”, których wyobrażenia o AI zakrawają o obrazy rodem z Terminatora mówiącego nam „hasta la vista, baby”. Rzeczywisty problem może jednak dotyczyć czegoś zupełnie innego. W ostatnim czasie część firm zaczęła redukować stanowiska juniorskie. Oczywiście niektóre z tych posad faktycznie można całkowicie zautomatyzować i są zbędne. Jednak wiele z nich pełni kluczową rolę w budowaniu przyszłych kadr, a ich likwidacja to poważny błąd. Może to doprowadzić do znaczącego niedoboru specjalistów w przyszłości – skąd mieliby się oni wziąć, jeśli nie będzie dla nich miejsc na start? To jednak nie jedyna nierozsądna decyzja firm. Kolejnym strzałem w kolano jest stosowanie AI w procesach rekrutacyjnych. To prawdopodobnie jedna z najgorszych możliwych strategii. Szablonów CV jest tyle, co kandydatów, a każdy człowiek jest inny. Tymczasem AI, kierując się sztywnymi wytycznymi, odrzuca aplikacje, w których brakuje określonych słów kluczowych lub staż pracy jest krótszy o zaledwie jeden miesiąc niż wymagany. W efekcie istnieje ogromne ryzyko pominięcia prawdziwej „perełki” idealnie pasującej na poszukiwane stanowisko. Nie wspominając już o tym, że większość ludzi i tak bez mrugnięcia okiem koloryzuje swoje CV oraz profile na „linkedinach” czy innych social mediach – ale to temat na osobny artykuł.

Kolejne katastroficzne wizje rozciągane są na artystów i szeroko pojętą sztukę, na to jak czyhający za rogiem AI zagrabi cały rynek obrazów, filmów, muzyki generując wszystko za ludzi. Na pierwszy rzut oka może to robić wrażenie, ale w rzeczywistości te obrazy wytworzone przez AI nie mają „duszy”. Ich powtarzalność i sztuczność wynika bowiem z faktu, że AI bazuje na obrazach i informacjach już stworzonych, jedynie je mieszając. To oznacza, że wszelkie obrazy, filmy, czy muzyka wygenerowane przez AI są w istocie wynikiem przetwarzania ogromnych ilości istniejących informacji, a nie tworzeniem czegoś zupełnie nowego. Nie ma w tym procesie wewnętrznej refleksji, intuicji czy inspiracji – czynników, które odgrywają kluczową rolę w ludzkiej kreatywności. W efekcie, nawet jeśli dzieła AI mogą być technicznie doskonałe, to często brak im głębi i emocji, które sprawiają, że sztuka człowieka potrafi poruszać. Ktoś może zaprotestować słowami, czym się różni tworzenie człowieka od tworzenia maszyny? Odpowiedź leży właśnie w tej intencji, emocjach i oryginalności, które są nieodłącznym elementem ludzkiego procesu twórczego. Człowiek nie działa jedynie na podstawie wzorców – to jego unikalne spojrzenie na świat, przeżycia i emocje nadają twórczości autentyczność, której AI po prostu nie potrafi naśladować.

Zakładając, że „nasze” AI jest prawdziwą sztuczną inteligencją, potrafiącą rozumować logicznie i podejmować decyzje, AI jest mało imponujące i niewydajne. Wszelkie czaty AI wykładają się na prostych zagadkach logicznych, a generowane obrazy pozostawiają wiele do życzenia w swoim braku logiczności. Ale czego mamy się spodziewać, jeśli Spotify, czy Netflix ma problem z trywialnymi algorytmami rekomendacyjnymi dla swoich odbiorców? Więc nie ma się co dziwić, że dla bardziej złożonych zadań AI dostaje segmenta na ryj. Niektórzy chwalą się, że AI przeszedł test Turinga. W mojej opinii, to nic nie znaczy. Problem w tym, że każdy taki test który stworzymy, będzie algorytmiczny, ponieważ w taki sposób konstruujemy testy. Komputery zawsze je pokonają. Potrzebujemy lepszej metodologii testowania inteligencji przy obecnym poziomie i zasobach informacji z których korzysta testowany program.

Cały rozgłos towarzyszący AI przypomina mi poprzednie nagonki np. na komputery kwantowe, a wiemy co się z tym stało, a raczej co się nie stało. Kończąc ten wpis chciałbym jedynie podkreślić, że postęp w rozwiązaniach typu AI jest faktem i sam korzystam z wielu takich narzędzi. Uważam, że czaty AI to obecnie najlepsze dostępne narzędzie do poprawy tekstów (gramatyka, język), wyszukiwania informacji czy szybkiego generowania podsumowań. Dziwi mnie jednak, jak łatwo środowisko się polaryzuje i nie dostrzega zagrożenia AI pod kątem ogłupiania społeczeństwa. Chodzi tutaj w szczególności o problemy, które można rozwiązać w „klasyczny” sposób. Chciałbym zaapelować, do Ciebie czytelniku: jeśli masz problem, który myślisz, że da się rozwiązać analitycznie, zrób to! AI zostaw jako rozwiązanie ostateczne.

Bibliografia

- S. Luccioni, Y. Jernite, and E. Strubell, Power hungry processing: Watts driving the cost of AI deployment? The 2024 ACM Conference on Fairness, Accountability, and Transparency (2024). ↩

- A. de Vries, The growing energy footprint of artificial intelligence, Joule, 7(10), 2191–2194 (2023) ↩